Data Mining (Buch) 3. Auflage

In den riesigen Datenbergen moderner Datenbanken steckt unentdecktes Wissen, das ohne geeignete Hilfsmittel kaum zu Tage gefördert werden kann. Hier setzt das Data Mining an und liefert Methoden und Algorithmen, um bisher unbekannte Zusammenhänge zu entdecken.

Das Buch deckt den Stoff einer einsemestrigen Vorlesung zu Data Mining an Universitäten und Fachhochschulen ab und ist als klassisches Lehrbuch konzipiert.

Kapitel 1 - Einführung

Dieses Kapitel gibt eine allgemeine Einführung in das Gebiet des Data Mining und klärt einige grundlegende Begriffe.

- Was ist, was kann Data Mining?

- Struktur des Buchs

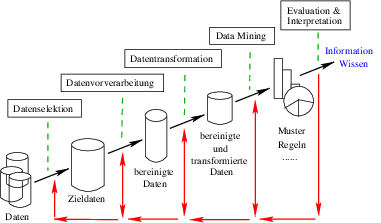

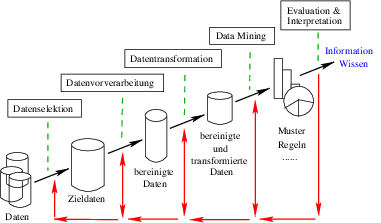

- Ablauf einer Datenanalyse

- Interdisziplinarität

- Tools

Dateien

- [1] Wetterdaten, numerisch, [2] Wetterdaten, nominal

- [3] Knime-Wetterworkflow Abb 1.6 / 1.8 (evtl. müssen Sie den FileReader konfigurieren)

- [4] Irisdaten, arff-Format

- [5] Knime-Loops Abb. 1.13 (evtl. müssen Sie den FileReader konfigurieren)

Tools

- Knime: http://www.knime.org/

- WEKA: http://www.cs.waikato.ac.nz/ml/weka/

- JavaNNS: http://www.ra.cs.uni-tuebingen.de/software/JavaNNS/

- Rapid Miner http://rapid-i.com

Wettbewerbe

- Data Mining Cup: http://www.data-mining-cup.de/

- Kaggle: http://www.kaggle.com/ (Data-Mining-Aufgaben)

Datensammlungen

- Kaggle: http://www.kaggle.com/

- Open Data Inception opendatainception.io

- Google Clud https://cloud.google.com/public-datasets/

- GitHub https://github.com/awesomedata/awesome-public-datasets

- Open Data on AWS https://registry.opendata.aws/

- EU Open Data Portal https://data.europa.eu/euodp/en/data/

- World-Bank https://data.worldbank.org/

- WHO https://www.who.int/gho/database/en/

- Data.gov catalog.data.gov/dataset

Kapitel 2 - Grundlagen

Dieses Kapitel klärt einige grundlegende Begriffe.

- Grundbegriffe

- Datentypen

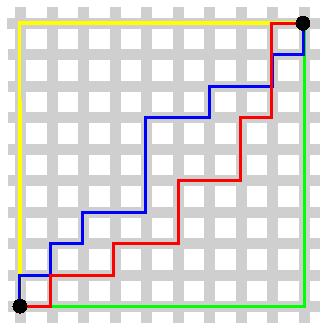

- Ähnlichkeits- / Abstandsmaße

- Grundlagen Künstlicher Neuronaler Netze

- Logik

- Überwachtes und unüberwachtes Lernen

Kapitel 3 - Anwendungsklassen

Dieses Kapitel gibt einen Überblick über die Anwendungsklassen im Data Mining.

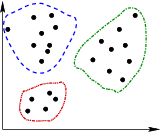

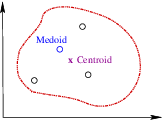

- Cluster-Analyse

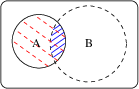

- Klassifikation

- Numerische Vorhersage

- Assoziationsanalyse

- Text Mining

- Web Mining

Kapitel 4 - Wissensrepräsentation

Dieses Kapitel gibt einen Überblick über die Möglichkeiten der Repräsentation von (DM-)Wissen auf einem Computer.

- Entscheidungstabelle

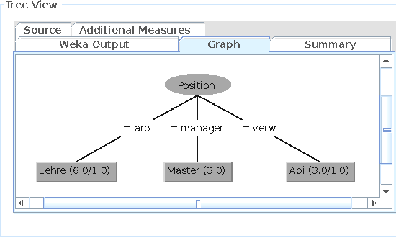

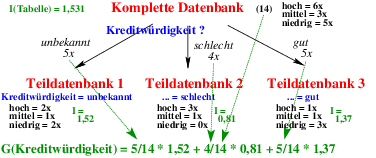

- Entscheidungsbäume

- Regeln

- Assoziationsregeln

- Instanzenbasierte Darstellung

- Repräsentation von Clustern

- Neuronale Netze als Wissensspeicher

Kapitel 5 - Klassifikation

Dieses Kapitel gibt einen Überblick über grundlegende Klassifikationsverfahren.

- k-Nearest Neighbour

- Entscheidungsbäume

- Naive Bayes

- Vorwärtsgreichtete NN

- SVM

Dateien

Kapitel 6 - Clusteranalyse

Kapitel 7 - Assoziationsanalyse

Dieses Kapitel gibt einen Überblick über grundlegende Verfahren zur Assoziationsanalyse.

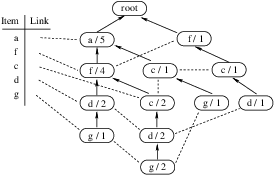

- A-Priori

- Frequent Pattern Growth

Dateien

- [1] Gesund/Krank-Daten, csv-Format (Tab. 7.1)

- Link auf die Umfrage 2006

Kapitel 8 - Datenvorbereitung

Dieses Kapitel gibt einen Überblick über grundlegende Techniken der Datenvorbereitung.

- Datenselektion und -integration

- Datensäuberung

- Datenreduktion

- Datentransformation

Dateien

Kapitel 10 - Beispiel

Dieses Kapitel diskutiert mögliche Vorgehensweisen beim [1]Data Mining Cup 2002.

Bestwert im DM-Cup 2002

- 12.12.13 Tanja Ciernioch (Hochschule Wismar): 7771,80

Dateien

- [2]Knime-Workflow für den ersten Versuch (Abb. 10.1).

- [3]Knime-Workflow für kNN (Abb. 10.5).

- [4]Knime-Workflow für Naive Bayes (Abb. 10.6).

- [5]Knime-Workflow 1 für DecTree (Abb. 10.7).

- [6]Knime-Workflow 2 für DecTree (Abb. 10.8).

- [7]Knime-Workflow 1 für NN (Abb. 10.9).

Fehler (1. Auflage)

- S. 261: Beim Naive Bayes Learner (Abb. 10.6) muss das "k=3" weg.

Korrekturen 3. Auflage

Gibt es ein Buch ohne Fehler? Leider nein. Hier einige Korrekturen für die 3. Auflage:

- S 105: In Abbildung 5.8 muss es Kredithistorie heißen, und nicht Kreditwürdigkeit.

- S. 108: In Abb. 5.11 muss im Zweig 15-35 / gut als Wert mittel stehen.

- S. 112: Die Gain-Werte sind vertauscht: Bei Variante 1 ergibt sich 0,65, bei Variante 2 0,44.

- S. 131, Formel 5.21: Das erste t-1 muss ein t sein.

- S. 229ff.: Hier wollten wir eigentlich klar zwischen den Umwandlungen nominal -> metrisch und umgekehrt (Diskretisierung) trennen. Bei den Beispielen springen wir dann doch zwischen beiden Umwandlungen hin und her.

- S. 241, letzter Absatz: Wir wollen einen Entscheidungsbaum mittels ID3 für den Bildungsabschluss (nicht das Jahresgehalt) generieren. Weiterhin müssten wir die Daten nicht transformieren, wenn wir den C4.5 anwenden wollten.

- S. 251, Beispiel 9.3: Der Support der Regel ist natürlich 20%, nicht 15%.